#3 IA Generativa (1): Introducción simplificada a la magia digital

¿Alguna vez soñaste con un asistente personal capaz de generar nuevas ideas, resolver dudas complejas, organizarte tu calendario, etc? Pues aquí lo tienes explicado siguiendo la técnica de Feynman!

Introducción

Antes de comenzar, quiero transmitir que he decidido lanzar una serie de varios artículos donde voy a intentar simplificar al máximo cualquier concepto relacionado con este tema de manera que sea accesible a cualquier persona sin un conocimiento previo. Además he incluido una sorpresita al final. Como decía el gran Richard Feynman: "Si no puedes explicar algo de manera tan simple que hasta un niño de cinco años lo capte, entonces no lo entiendes lo suficiente."

Aunque sé que muchos de ustedes son muy muy curiosos y ya habrán trasteado con ChatGPT o incluso creados bots/GPTs personalizados para una tarea en particular; quizás pocos se hayan planteado como funciona toda esta magia.

Y les soy sincero, tratándose de una herramienta con tanto impacto en nuestro día a día y que está cambiando y va a cambiar/crear muchos trabajos en un futuro próximo, tener conocimientos de sus tripas te confiere una ventaja considerable tanto para aprender a interactuar con ellos y recibir una respuesta lo más alineada posible a tu objetivo como a la hora de evaluar los resultados que obtienes (lo veremos más adelante como un ejemplo).

Estos modelos tratan de dar siempre respuestas coherentes, pero en ciertas ocasiones, si una persona con un nivel de conocimiento más amplio en la materia tratada lo leyera, diría que no tiene ni pies ni cabeza.

Iniciamos

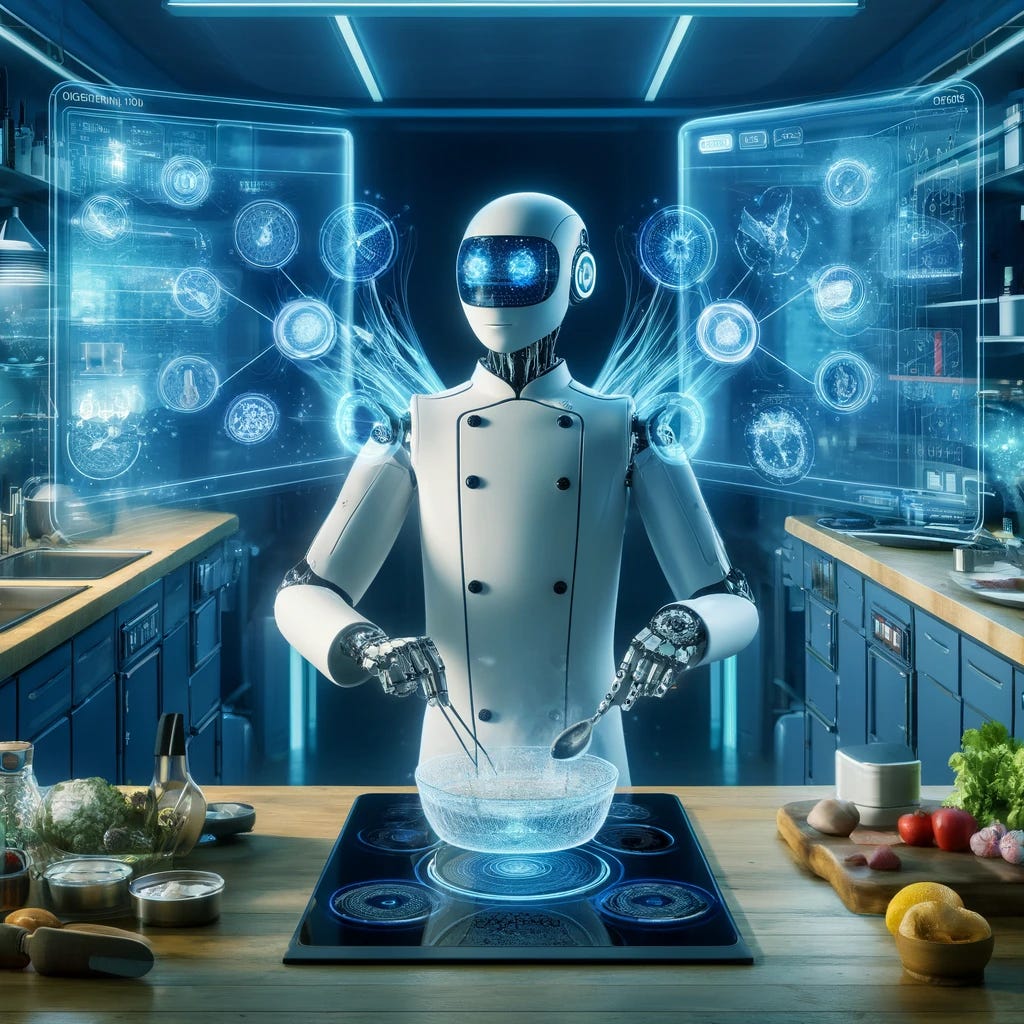

La Inteligencia Artificial generativa, o IA generativa, puede parecer un término complejo, pero su concepto es sencillo de entender. Para los más cocinitas (yo me incluyo), imagínense enseñar a un ordenador/robot a ser un super cocinero creativo. Para ello que hacemos, lo primero es mostrarle cientos, miles o incluso millones de recetas que existen en la web u otras fuentes adicionales. Él las engulle todas (los bits, no la comida que es un cocinero fit) y nos crea una ventanita donde poder abrir diálogo y pedirle que nos genere una receta en base a todo lo que ha aprendido. Eso es, simplificadísimo, lo que hace esta tecnología.

La IA generativa es un programa que toma grandes cantidades de datos y encuentra patrones en ellos. Luego, utiliza estos patrones para hacer predicciones cuando se le solicita (prompt).

Pero aquí entra un punto importante, según las palabras que usamos cuando le pedimos una receta, la respuesta que nuestro super creativo chef nos da, varía. Una mínima diferencia en la sugerencia o prompt, como mejor se le conoce en este mundillo, genera una respuesta totalmente distinta (os dejo los enlaces por si quieren explorarlo, ojo que ni se me ha pasado por la cabeza realizarlas pero si hay algún valiente, adelante!):

¿Cómo es posible esto?

Para entender cómo funcionan estos modelos de generación de texto, también conocidos como Large Language Models (LLM) o en español (Modelos de lenguaje grande/de gran tamaño), podemos imaginarlos como una gran red de neuronas en nuestro cerebro. Estas neuronas están conectadas entre sí y cada una de ellas contiene información sobre una pequeña parte de lo que el modelo ha aprendido. Cuando le pedimos al modelo que genere texto, le damos un "impulso" inicial (el prompt) y este impulso se propaga a través de esta red, activando diferentes neuronas según la información que contienen. Al final, la respuesta del modelo es el resultado de esta activación colectiva.

Los modelos de lenguaje de gran tamaño, como GPT-4, poseen trillones de conexiones, permitiendo almacenar una inmensa cantidad de información. Sin embargo, su entendimiento del mundo no es igual al humano. No poseen experiencias ni emociones, y no comprenden el contexto de la misma forma que nosotros. Simplemente repiten patrones que han observado en los datos con los que han sido entrenados.

Ejemplo: Piensa en ChatGPT. Toma miles de millones de palabras y escanea cómo cada una de ellas se correlaciona con las demás. Ve la palabra "cielo" junto a la palabra "azul" 10 o 15,000 veces, y ahora puede decirte: el cielo es azul.

Puntos importantes: su alimentación, los sesgos, alucinaciones y la privacidad

Resulta ser un punto de gran importancia las fuentes de las cuales se alimentan estos modelos. Normalmente de la diversidad de textos disponibles en internet, incluyendo libros, artículos, sitios web, etc (aunque también se pueden personalizar para sólo absorber la información que elijamos, lo veremos más adelante).

Esta amplia gama de fuentes les permite aprender diferentes estilos de escritura, temas, y vocabularios. Sin embargo, las diferencias en los datos de entrenamiento puede generar respuestas sesgadas (orientadas hacia una corriente de pensamiento en particular). Por ejemplo, imagina un modelo entrenado con artículos de noticias de un solo espectro político; éste generaría principalmente respuestas que se inclinan hacia las opiniones de ese espectro, reflejándose los sesgos presentes en su fuentes de origen. Para combatir este fenómeno, es vital utilizar diversidad de fuentes y, sobre todo, crear modelos open source (de código abierto) para conocer con transparencia la procedencia de los datos. Os recomiendo el documental Sesgo Codificado en Netflix.

Por otro lado, tenemos las alucinaciones. En muchas situaciones, el modelo genera información falsa o inventada, presentándola como si fuera verdadera. Esto puede incluso ocurrir cuando el modelo ha sido entrenado en extensos conjuntos de datos. Por ejemplo, si le preguntas sobre un evento histórico ficticio, podría crear detalles específicos sobre ese evento, como fechas, personas involucradas, y consecuencias, a pesar de que nunca ocurrió. Este fenómeno resalta la importancia de verificar la información generada y realizar un buen prompting (veremos técnicas específicas en otro artículo). Pensamiento crítico equipo, es donde quiero el foco. Vivimos en un océano de desinformación y hay que pararse y filtrar adecuadamente.

En cuanto a la privacidad, tanto si lo usas para tu negocio como uso personal, puede ser tentador compartir información confidencial con herramientas como ChatGPT para obtener respuestas más personalizadas, pero es importante recordar que en muchos casos ésta se utiliza para entrenar a los modelos. Consejo: leerse primero la documentación de la plataforma donde vayamos a operar o asesorarse con alguien experto.

¿Cuántos de ustedes antes de comenzar a leer el articulo conocían la existencia de los sesgos, las alucinaciones o el papel de la privacidad? Os leo en comentarios.

Seguiremos quitando capas

Hasta aquí la primera entrega donde he intentado sintetizar el funcionamiento de estos modelos, sin meternos en aspectos muy muy técnicos ni mucha historia del origen, creación y evolución de estos. No obstante, si queréis entrar de lleno en ello me lo podéis comentar y os proporciono algunas fuentes.

Empecemos por lo básico y poco a poco vamos entrando en materia con casos más prácticos. Como dije al principio, prefiero que tengan unos buenos cimientos para multiplicar después los resultados y hacerlo con conocimiento de causa.

En el siguiente ya veremos aplicaciones y estrategias de prompting, pero os animo a irlo probando para que los conceptos que exploremos posteriormente se absorban de otra forma. Learning by doing is the key! (Aprender haciendo es la clave!)

Seguimos explorando juntos, como siempre vuestro feedback es vital para saber que os parece el formato y si es necesario hacer algún ajuste. El cambio es constante en la vida y la mejora infinita. ¡Gracias por vuestro tiempo!

Como les prometí, les dejo una pildorita muy útil: video breve para que vean como utilizo Notion Web Clipper para guardar artículos/webs en Notion y trabajar sobre ellos subrayando la info más relevante o tomando notas. También se puede hacer desde el móvil🤟.

Si aun no estás suscrito, no olvides hacerlo para estar al tanto de las próximas ediciones y compartirlo con todas aquellas personas que crees que podrían inspirarse también.

Hasta entonces, mantén viva tu curiosidad, sigue aprendiendo y, sobre todo, disfruta del proceso. ¡Nos vemos en la próxima edición de brainSynchro!

Qué gran artículo, Dimas!